Easyspider 如何解决我的日常数据抓取难题?

Easyspider 如何解决我的日常数据抓取难题?

Lifeline一、引言

数据抓取需求在工作和研究中日益普遍,但技术门槛常成为拦路虎。Easyspider作为可视化爬虫工具,通过图形化操作降低使用难度。它让零编程基础的用户也能高效获取网络数据。该工具支持从电商价格到学术资料的多场景采集,开源特性更保障了灵活性和安全性。

日常数据抓取常面临反爬机制和动态页面等复杂问题。传统爬虫需专业开发者耗时解决,而Easyspider内置智能应对方案。自动化流程设计可一键处理分页登录等操作,浏览器内核直接渲染动态内容,大幅提升数据获取成功率。

二、代码恐惧如何破解?

非技术用户面对数据抓取常因代码要求却步,手动收集又效率低下。Easyspider通过可视化点选操作替代编程,流程图界面直观展示采集逻辑。拖拽式工作流设计彻底消除编程障碍,实时预览功能确保规则准确性,日志面板清晰反馈执行过程。

三、复杂网站如何抓取?

动态加载、登录验证等场景使常规爬虫失效,反爬机制更导致IP封锁风险。Easyspider采用真实浏览器内核渲染页面,智能处理AJAX请求与JavaScript交互。自动化等待机制确保动态内容完整加载,代理轮换功能有效规避访问限制。

- 动态渲染支持:内置Chromium引擎解析JS动态内容

- 智能等待系统:自动检测元素加载完成再抓取

- 验证码应对:人工干预模式破解复杂验证

- 反爬策略:请求头伪装与IP代理池防护

四、数据管理如何高效?

碎片化数据需耗费大量时间清洗整理,多平台协作更增加管理成本。Easyspider提供结构化输出与自动化管道,任务调度实现无人值守定时采集。版本控制功能追踪规则变更,云同步保障团队协作效率。

- 智能导出:CSV/Excel/数据库多格式一键输出

- 定时任务:设置周期采集自动更新数据

- 增量抓取:智能识别新内容避免重复

- 规则版本管理:备份和恢复采集配置防丢失

五、主流工具横向对比

| 功能 | Easyspider | 八爪鱼 | WebScraper | Scrapy |

|---|---|---|---|---|

| 可视化操作 | ✔️ | ✔️ | ✔️ | ✘ |

| 动态页面支持 | ✔️ | ✔️ | ✘ | 需插件 |

| 开源免费 | ✔️ | 部分收费 | ✔️ | ✔️ |

| 定时任务 | ✔️ | ✔️ | ✘ | 需部署 |

| 数据清洗功能 | 内置 | 高级版 | 基础 | 需编程 |

六、场景应用深度挖掘

Easyspider的价值在具体场景中持续释放潜能。从竞品监控到学术研究,灵活适应各类数据采集维度。其扩展接口支持二次开发,满足企业级定制需求,生态社区不断贡献新应用方案。

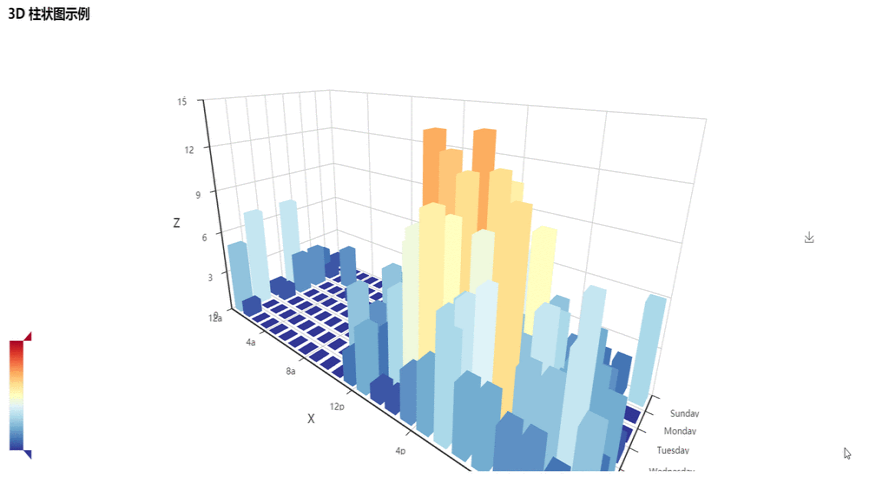

- 价格监控体系:电商平台价格波动自动追踪

- 舆情分析网络:多源新闻社交数据实时聚合

- 学术资料库构建:期刊论文元数据批量获取

- 商业情报收集:竞品信息自动化监测预警

七、结论

Easyspider通过可视化与智能化的结合,有效破解日常数据抓取的核心痛点。从降低技术门槛到应对复杂场景,形成完整解决方案链。它正重新定义普通人获取网络数据的能力边界,未来将持续优化数据处理闭环,让数据价值挖掘更高效民主化。

评论

匿名评论隐私政策